RWKV 社区十二月动态:10 篇新论文,Bo 的 2025 总结

欢迎大家收看《rwkv 社区最新动态》,本期内容收录了 rwkv 社区 2025 年 12 月的最新动态。

12 月动态省流版(tl;DR)

-

RWKV 模型新闻动态

- RWKV7-G0b 13.3B 发布

-

RWKV 学术研究动态

- RWKV-SKF: A recurrent architecture with state-space and frequency-domain filtering for dissolved oxygen predicting and revealing influencing mechani *** s(基于 RWKV 的溶解氧预测,发表于 JCR Q1 分区的 Information Sciences)

- Robin: RWKV Accelerator using Block Circulant Matrices based on FPGA(基于 FPGA 的 RWKV 加速器,发表于 CCF B 类会议 ICCAD)

- DME-RWKV: An Interpretable Multimodal Deep Learning Framework for Predicting Anti-VEGF Response in Diabetic Macular Edema(基于 RWKV 的糖尿病黄斑水肿治疗反应预测,发表于 Bioengineering)

- SemanticBBV: A Semantic Signature for Cross-Program Knowledge Reuse in Microarchitecture Simulation(基于 RWKV 的程序分析与微架构模拟,发表于 ASP-DAC 2026)

- EG-Net: Edge-Global aware network for accurate skin lesion segmentation(基于 RWKV 的皮肤病变分割,发表于 中科院 2 区期刊 BSPC)

- AFF-UNet-RWKV: A Lightweight Model for High-Quality Deblurring in Medical Imaging(基于 RWKV 的医学图像去模糊)

- RWKVSR: Receptance Weighted Key-Value Network for Hyperspectral Image Super-Resolution(基于 RWKV 的高光谱图像超分辨率)

- LADY: Linear Attention for Autonomous Driving Efficiency without Transformers(基于 RWKV 的端到端自动驾驶)

- FRWKV: Frequency-Domain Linear Attention for Long-Term Time Series Forecasting(基于 RWKV 的长期时间序列预测)

- Fourier-RWKV: A Multi-State Perception Network for Efficient Image Dehazing(基于 RWKV 的图像去雾)

-

RWKV 社区市场活动

- RWKV 社区举办第二届开发者大会

-

RWKV 社区项目动态

- ROSA-soft

- ROSA-tuning

- RWKV State Tuning 实战

-

特刊:PENG Bo 的 2025 年度总结

RWKV 模型新闻动态

2025 年 11 月 30 日, RWKV7-G0b 13.3B 推理模型开源发布。它基于 RWKV7-G0a4 13.3B 继续训练高质量数据,显著提升各项能力。

详细报道:RWKV7-G0b 13.3B 发布:RNN 的新一步

RWKV 学术研究动态

RWKV-SKF

- 论文名称:RWKV-SKF: A recurrent architecture with state-space and frequency-domain filtering for dissolved oxygen predicting and revealing influencing mechani *** s

- 论文链接:https://www.sciencedirect.com/science/article/abs/pii/S0020025525011557

- 发布日期:2025-12-24

该研究基于 RWKV 架构,提出了 RWKV-SKF 框架,通过融合状态空间卡尔曼滤波与频域傅里叶滤波,有效处理传感器噪声与周期性动态,以提升溶解氧预测精度。实验证明该模型性能优越,并能揭示关键影响机制。

论文发表于 Information Sciences(JCR Q1 分区),在环境监测领域应用表现出色。

Robin

- 论文名称:Robin: RWKV Accelerator using Block Circulant Matrices based on FPGA

- 论文链接:https://ieeexplore.ieee.org/document/11240845

- 发布日期:2025-11-20

论文介绍了 Robin,一种针对 RWKV 线性注意力模型的 FPGA 加速器软硬件协同设计方案。为了解决 RWKV 在 FPGA 上的存储和计算瓶颈,Robin 在算法层提出了部分块循环矩阵(PBCM)技术来压缩权重并保持精度;在硬件层设计了可配置循环计算核心,利用 DSP 封装策略高效支持循环和标准矩阵运算。实验显示,相比 Tesla A100 GPU,Robin 实现了高达 3.09 倍的吞吐量提升和 7.31 倍的能效提升。

论文效果出色,发表于 CCF B 类会议 ICCAD。

DME-RWKV

- 论文名称:DME-RWKV: An Interpretable Multimodal Deep Learning Framework for Predicting Anti-VEGF Response in Diabetic Macular Edema

- 论文链接:https://www.mdpi.com/2306-5354/13/1/12

- 发布日期:2025-12-21

本研究基于 RWKV 架构提出了 DME-RWKV 模型,用于预测糖尿病黄斑水肿(DME)患者对抗 VEGF 治疗的反应。该模型融合了 OCT 和超广角成像,并结合因果注意力学习等 *** ,在生物标志物分割和治疗反应预测任务上均表现出色,具有高精度和可解释性。

论文模型新颖高效,发表于 Bioengineering。

SemanticBBV

- 论文名称:SemanticBBV: A Semantic Signature for Cross-Program Knowledge Reuse in Microarchitecture Simulation

- 论文链接:https://arxiv.org/abs/2512.10231

- 发布日期:2025-12-11

该论文提出 SemanticBBV,使用轻量级 RWKV 编码器生成语义签名,以解决传统 BBV 无法跨程序重用知识的问题。它通过 Set Transformer 聚合嵌入并联合训练,实现了跨程序性能估计,显著加速了微架构模拟。

论文显著加速了微架构模拟,发表于 ASP-DAC 2026。

EG-Net

- 论文名称:EG-Net: Edge-Global aware network for accurate skin lesion segmentation

- 论文链接:https://www.sciencedirect.com/science/article/abs/pii/S1746809425018142

- 发布日期:2025-12-01

该研究利用 RWKV 构建边缘-全局特征融合模块,以增强皮肤病变分割的全局上下文建模能力。结合边缘特征提取与通道增强解码器,EG-Net 有效解决了病变边界模糊问题,在多个公开数据集上实现了超越 SOTA 的精度与泛化性。

论文效果出色,发表于中科院 2 区的 BSPC。

AFF-UNet-RWKV

- 论文名称:AFF-UNet-RWKV: A Lightweight Model for High-Quality Deblurring in Medical Imaging

- 论文链接:https://madison-proceedings.com/index.php/aetr/article/view/4338

- 发布日期:2025-11-20

本文提出的 AFF-UNet-RWKV 模型,通过集成 RWKV-lite 空间混合器来捕获长程空间依赖,并结合 AFF 模块融合编解码器特征,实现了高效的医学图像去模糊。该轻量级模型在 PSNR 和 SSIM 指标上均优于传统 *** ,展现了优越的恢复性能。

论文在多项指标上均优于传统 *** ,展现了卓越的恢复性能。

RWKVSR

- 论文名称:RWKVSR: Receptance Weighted Key-Value Network for Hyperspectral Image Super-Resolution

- 论文链接:https://ieeexplore.ieee.org/document/11222729

- 发布日期:2025-10-30

RWKVSR 引入了 RWKV 架构用于高光谱图像超分辨率,通过线性复杂度模块实现高效全局建模,结合方向可分离 3D 卷积和频域损失优化光谱一致性,在多个数据集上实现更佳性能。

论文在多个数据集上实现更佳性能,效果优异。

LADY

- 论文名称:LADY: Linear Attention for Autonomous Driving Efficiency without Transformers

- 论文链接:https://arxiv.org/abs/2512.15038

- 发布日期:2025-12-17

该研究基于 RWKV-7 模型提出首个完全线性注意力的端到端自动驾驶框架 LADY。它通过轻量级线 *** 叉注意力机制,高效融合多帧传感器数据,实现恒定计算与内存开销。实验证明 LADY 在提升规划性能的同时显著降低计算成本,并已在边缘设备部署验证。

论文在提升性能的同时显著降低了计算成本,表现出众。

FRWKV

- 论文名称:FRWKV:Frequency-Domain Linear Attention for Long-Term Time Series Forecasting

- 论文链接:https://arxiv.org/abs/2512.07539

- 发布日期:2025-12-09

受 RWKV 线性注意力启发,本文提出了 FRWKV 模型,将线性注意力与频域分析相结合,用于长期时间序列预测。该 *** 在频域中实现 O(T) 复杂度的线性注意力,有效利用频谱信息增强特征表示,在多个基准测试中取得了领先性能。

论文在多个基准测试中取得了领先性能,效果显著。

Open Voice OS

Open Voice OS

OpenVoiceoS是一个社区驱动的开源语音AI平台

下载Fourier-RWKV

- 论文名称:Fourier-RWKV: A Multi-State Perception Network for Efficient Image Dehazing

- 论文链接:https://arxiv.org/abs/2512.08161

- 发布日期:2025-12-09

Fourier-RWKV 通过将 WKV 注意力机制扩展至频域来解决图像去雾问题。该模型融合了空间、频域与语义三种感知状态,以线性复杂度实现了 SOTA 性能,有效平衡了恢复质量与计算效率。

论文以线性复杂度实现了 SOTA 性能,效果非凡。

社区市场活动

RWKV 社区举办第二届开发者大会

2025 年 12 月 13 日,RWKV 在上海漕河泾举办了主题为《RWKV-8 与未来趋势》的 2025 RWKV DevDay。

十位来自 RWKV 开源社区的重磅嘉宾带来了深度分享,内容涵盖 RWKV-8 的核心 ROSA 机制、并发推理、端侧推理优化、评测 *** ,以及 RWKV 最新生态进展等多个维度。

详细报道:RWKV DevDay 2025 圆满落幕,看见 RWKV-8 的无限可能!

RWKV 社区项目动态

ROSA-tuning

ROSA-Tuning将 ROSA 机制与现代大型语言模型相结合,使它们能够仅使用固定长度的注意力窗口来处理任意长的输入,同时实现接近完全全局注意力的性能。

项目地址:https://github.com/zyaaa-ux/ROSA-Tuning

ROSA-soft

本项目提供了一个强大的、可端到端训练的ROSA(Rapid Online Suffix Automaton)算子实现。我们通过采用直通估计器(STE)框架,使离散的、不可微分的ROSA机制与基于梯度的优化兼容。

项目地址:https://github.com/wjie98/rosa_soft

RWKV State Tuning 实战

仅需 8G 显存(一张 4060)即可训练一个可以正常进行 function call,并根据设定内容进行回复的模型!最终训练出的 state 仅 10M,搭载 2.9B 模型,边缘设备也可部署!

详细报道:RWKV State Tuning实战:8G显存训练AI助手(带function call)

特刊:PENG Bo 的 2025 年度总结

转自知乎用户 PENG Bo,原文链接:https://www.zhihu.com/question/1974931646080836522/answer/1987541572955416201?share_code=DcUETlkRnH7K&utm_psn=1987588920150618890

谢邀,首先感谢 RWKV 社区的支持,我们刚刚举办了 RWKV8 ROSA 开发者大会:

今年我发过的 RWKV 模型(每个参数量都是越新越显著强,请大家记得永远用最新模型)。 模型下载和 GGUF 见:https://huggingface.co/BlinkDL/rwkv7-g1

? RWKV 模型发布列表

| 模型版本 | 参数量 | 文件名 |

|---|---|---|

| RWKV7-G0b | 7.2B | rwkv7-g0b-7.2b-20251220-ctx8192.pth |

| RWKV7-G0a4 | 7.2B | rwkv7-g0a4-7.2b-20251208-ctx8192.pth |

| RWKV7-G1b | 2.9B | rwkv7-g1b-2.9b-20251205-ctx8192.pth |

| RWKV7-G1b | 1.5B | rwkv7-g1b-1.5b-20251202-ctx8192.pth |

| RWKV7-G0b | 13.3B | rwkv7-g0b-13.3b-20251130-ctx8192.pth |

| RWKV7-G1a4 | 2.9B | rwkv7-g1a4-2.9b-20251118-ctx8192.pth |

| RWKV7-G0a4 | 13.3B | rwkv7-g0a4-13.3b-20251114-ctx8192.pth |

| RWKV7-G1a3 | 2.9B | rwkv7-g1a3-2.9b-20251103-ctx8192.pth |

| RWKV7-G0a3 | 13.3B | rwkv7-g0a3-13.3b-20251031-ctx4096.pth |

| RWKV7-G0a3 | 7.2B | rwkv7-g0a3-7.2b-20251029-ctx8192.pth |

| RWKV7-G1a3 | 1.5B | rwkv7-g1a3-1.5b-20251015-ctx8192.pth |

| RWKV7-G1a2 | 1.5B | rwkv7-g1a2-1.5b-20251005-ctx8192.pth |

| RWKV7-G0a2 | 7.2B | rwkv7-g0a2-7.2b-20251005-ctx4096.pth |

| RWKV7-G1a | 2.9B | rwkv7-g1a-2.9b-20250924-ctx4096.pth |

| RWKV7-G1a | 1.5B | rwkv7-g1a-1.5b-20250922-ctx4096.pth |

| RWKV7-G1a | 0.4B | rwkv7-g1a-0.4b-20250905-ctx4096.pth |

| RWKV7-G0a | 7.2B | rwkv7-g0a-7.2b-20250829-ctx4096.pth |

| RWKV7b-G1b | 0.1B | rwkv7b-g1b-0.1b-20250822-ctx4096.pth |

| RWKV7a-G1b | 0.1B | rwkv7a-g1b-0.1b-20250819-ctx4096.pth |

| RWKV7-G1a | 0.1B | rwkv7-g1a-0.1b-20250728-ctx4096.pth |

| RWKV7-G0 | 7.2B | rwkv7-g0-7.2b-20250722-ctx4096.pth |

| RWKV7-G1 | 2.9B | rwkv7-g1-2.9b-20250519-ctx4096.pth |

| RWKV7-G1 | 1.5B | rwkv7-g1-1.5b-20250429-ctx4096.pth |

| RWKV7-G1 | 0.4B | rwkv7-g1-0.4b-20250324-ctx4096.pth |

| RWKV7-G1 | 0.1B | rwkv7-g1-0.1b-20250307-ctx4096.pth |

| RWKV-7 | 2.9B | RWKV-x070-World-2.9B-v3-20250211-ctx4096.pth |

| RWKV-7 | 1.5B | RWKV-x070-World-1.5B-v3-20250127-ctx4096.pth |

| RWKV-7 | 0.4B | RWKV-x070-World-0.4B-v2.9-20250107-ctx4096.pth |

受益于数据的进步,模型能力快速提升,例如这是 G0b 13.3B 的发布稿: 点击阅读文章

它在单显卡并行生成几十个网页的效果(看着空白的都实际内容正常,只是留白多,缩小看不到内容):

我还没开始真正的大规模蒸馏/刷榜,所以 2026 年的 RWKV 会强非常多,请大家期待。

以及目前在 rwkv.cn 可见 161 篇论文(还有些新的没放上来):

在 2026 年,我们会继续推进纯 RNN 的极限。欢迎大家关注 RWKV 官网:

- RWKV 中国:www.rwkv.cn/

- RWKV 国际:www.rwkv.com/

此外,您在 Play Store / App Store 外区,可搜索 RWKV chat(源代码在 GitHub),体验 RWKV 端侧离线 app(对话,图像,语音,等等):

效果例子:

? *** 与技术资源

最后,我们长期招实习生(尤其是 infra、后训练、多模态),不限学历,不限线上线下,只要您有热情+会用 AI,欢迎联系我们(您可以先加 RWKV 的各个 *** 群,然后在群里说)。

快速上手 RWKV 训练(单显卡几 G 显存就能玩):

- 训练代码目录: RWKV-LM/tree/main/RWKV-v7/train_temp

- 简化版训练脚本: rwkv7_train_simplified.py

- CUDA 加速内核: RWKV-CUDA/tree/main/rwkv7_fast_fused

- Albatross 项目: Albatross

️ 提示:训练 RWKV 时,记得正确初始化,记得只在大矩阵参数做 weight decay。

加入 RWKV 社区

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入 RWKV 论坛、 *** 频道和 *** 群聊,一起探讨 RWKV 模型。

- ? RWKV 中文文档:https://www.rwkv.cn

- ? RWKV 论坛:https://community.rwkv.cn/

- ? *** 频道:https://pd.qq.com/s/9n21eravc | *** 交流群:224287095

- ? BiliBili 视频教程:https://space.bilibili.com/3546689096910933

源码地址:点击下载

“RWKV 社区十二月动态:10 篇新论文,Bo 的 2025 总结” 的相关文章

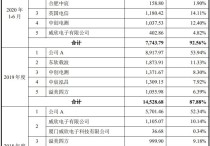

手握采购、研发、销售三条“命脉” 谁是操控创耀科技命运的神秘“公司A”

1947年,美国贝尔实验室的威廉.肖克利和他的两位助手布拉顿、巴丁,研制出了世界上第一只晶体管,为集成电路产业打开时代大门,也造就了现代信息社会的根基――“芯片”。 但是现代信息社会并不能避不开国与国之间的问题。 “芯片强则产业强,芯片兴则经济兴,没有高端芯片就没有真正的产业安全和国...

威腾电气IPO观察:自夸“头部企业”被打回原形 拿投资者4个亿只为“试试水”?

威腾电气,一家缺乏科创属性、爱夸夸其谈还带着问题供应商的公司,正在冲击科创板市场。 2021年1月14日,以输配电中母线产品研发、制造及销售为主业的威腾电气,正式通过上市委会议,距离科创板上市又近了一步。 但这对投资者而言,可能并不是一件好事。 由于身在传统电力行业,科研步伐又...

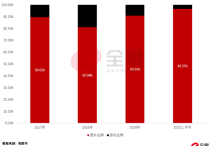

市占率不足0.1% 造血能力不足 罗普特科创上市谋续命?

钱流不进口袋的企业,真的算是赚钱企业吗? 盈利,是大部分投资者最关心的问题。但企业盈利的有效性,是有前提的,现金流就是这个前提。但这部分,往往会被许多投资者忽略,正如巴菲特的那句著名评论:“现金是氧气,99%的时间你不会注意它,直到它没有了”。 没有现金流入的盈利只是纸面数字,纸面数...

19%市占率换不来业绩体量的和林微纳 新业务0.24%市占率又该如何期待?

以19%市占率位居精微屏蔽罩市场头部玩家的和林微纳,即将亮相科创板。 2021年3月9日,主要产品为微机电(MEMS)精微电子零部件的和林微纳,开启了科创板招股。公司与楼氏电子、瑞声科技、裕元电子和银河机械,一同成为精微屏蔽罩市场的主要玩家,2019年五家企业合计占到全球市场总份额的80%...

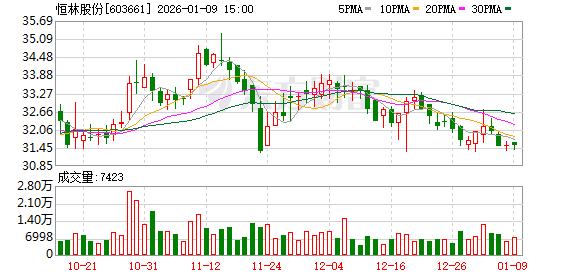

新风光:核心材料严重依赖进口 毛利率下滑市场“风光”不再 |

作为“光伏、风电”等大热门行业上游关键零部件供应商的新风光,即将登陆科创资本市场。 2021年3月24日,以大功率电力电子节能控制技术为核心技术平台,构筑电气控制装备产品体系的新风光,在科创板开启招股环节。 招股资料显示,新风光本次共计将募资5.9亿元,其中1.5亿元用于变频器和SV...

华恒生物:近半市占率的细分龙头 竟然只能“被动挨打”丨

全球最大的丙氨酸生产商华恒生物,即将亮相科创资本市场。 2021年4月7日,以合成生物技术为核心,主要从事氨基酸及其衍生物产品研发、生产、销售的华恒生物,于科创板开启了路演询价环节,距离正式亮相科创板仅剩一步之遥。 图/Wind 目前,华恒生物拥有接近50%的市场占有率...